Introduction

Les intelligences artificielles (IA) comme ChatGPT, Claude ou Gemini sont devenues des outils puissants pour nous aider à rédiger, analyser, créer du contenu ou résoudre des problèmes. Mais elles ne sont pas infaillibles.

L’un des phénomènes les plus souvent pointés du doigt s’appelle l’hallucination : c’est lorsque l’IA produit une réponse fausse, inventée ou trompeuse… tout en la présentant avec confiance et fluidité.

Ces erreurs ne sont pas anodines : elles peuvent semer le doute, induire en erreur ou donner une fausse impression de fiabilité. Alors, pourquoi cela arrive ? Est-ce lié à notre propre manière de raisonner ? Et surtout, comment s’en protéger ?

Qu’est-ce qu’une hallucination en IA ?

On parle d’hallucination lorsqu’une IA génère une information qui semble crédible mais qui est factuellement fausse ou inventée.

Exemples concrets :

- Inventer une citation attribuée à un auteur célèbre.

- Fournir une référence d’article ou un lien qui n’existe pas.

- Expliquer un concept de manière convaincante, mais incorrecte.

En bref : l’IA ne “sait” pas qu’elle se trompe. Elle poursuit simplement son objectif premier : produire du texte fluide, pertinent en apparence.

Pourquoi les IA hallucinent-elles ?

- Un fonctionnement probabiliste Les IA génératives (comme ChatGPT) ne raisonnent pas comme nous. Elles ne cherchent pas la vérité, elles prédisent la suite de mots la plus probable selon les milliards de données sur lesquelles elles ont été entraînées. ➡ Résultat : elles peuvent assembler des morceaux plausibles qui… ne correspondent pas à la réalité.

- Des données imparfaites Les modèles sont entraînés sur des données issues d’Internet, de livres, d’articles. Or, ces sources contiennent des erreurs, des contradictions, des biais humains. ➡ En quelque sorte, les IA héritent de nos propres travers.

- La pression du contexte Quand une question est posée, l’IA “veut” répondre, même si la donnée exacte n’existe pas dans sa mémoire. Elle préfère inventer une réponse plausible plutôt que de dire “je ne sais pas”. ➡ Cela reflète notre propre tendance humaine : combien de fois donnons-nous une réponse approximative plutôt que d’admettre notre ignorance ?

- Un reflet de nos biais cognitifs Nos cerveaux fonctionnent avec des raccourcis (les biais cognitifs) : généralisation, simplification, illusion de savoir… Les IA, construites sur nos textes, reproduisent en partie ces biais.

L’hallucination est-elle vraiment « humaine » ?

Oui, dans une certaine mesure.

- Comme nous, l’IA comble les trous quand il lui manque une information.

- Comme nous, elle préférait être cohérente plutôt qu’exacte.

- Comme nous, elle peut être influencée par le contexte et les biais des données.

La grande différence :

- Chez l’humain, une intuition ou une erreur peut être corrigée par l’expérience et le jugement critique.

- Chez l’IA, le discernement ne vient pas de l’intérieur, mais de l’utilisateur qui la consulte.

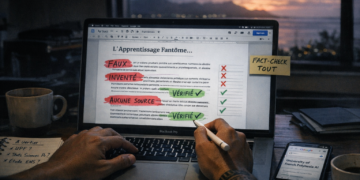

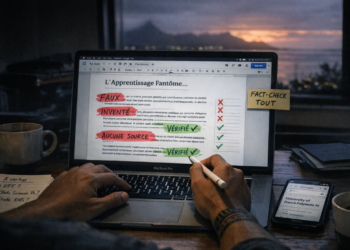

Comment réduire les hallucinations ?

- Vérifier systématiquement les sources Toujours demander à l’IA de fournir des références précises et les contrôler ensuite (dates, liens, auteurs).

- Recouper les informations Ne jamais se contenter d’une seule réponse. Poser la même question de plusieurs manières, ou comparer avec d’autres IA.

- Utiliser des données spécialisées Les IA hallucinent moins lorsqu’elles sont connectées à des bases fiables et actualisées (bases médicales, juridiques, scientifiques…).

- Encourager l’IA à dire “je ne sais pas” Certaines formulations de prompts réduisent les inventions :

- “Si tu n’es pas sûr, indique-le.”

- “Ne génère pas de réponse inventée.”

- “Je ne veux pas d’une réponse complaisante.”

- “Ne me donne pas une réponse pour me faire plaisir.”

- “Donne moi une réponse en toute objectivité.”

- Garder son esprit critique Ne jamais oublier que l’IA ne pense pas, n’a pas de conscience, et ne détient pas la vérité. Elle propose un texte. C’est à l’humain d’analyser et valider.

Pourquoi le discernement reste essentiel

L’IA est une aide incroyable, un accélérateur, un compagnon de travail. Mais elle ne doit jamais remplacer le jugement humain.

➡ Le risque des hallucinations, c’est d’accepter une réponse sans la vérifier.

➡ Le vrai pouvoir de l’IA, c’est quand elle devient un outil de réflexion, pas une vérité absolue.

En d’autres termes :

- Avec discernement, l’IA décuple nos capacités.

- Sans discernement, elle peut nous induire en erreur.

Conclusion

Les hallucinations en intelligence artificielle ne sont pas un bug isolé, mais une conséquence logique de leur mode de fonctionnement. Elles reflètent nos propres biais humains et nos tendances à combler les vides par du plausible.

La solution n’est donc pas d’abandonner l’IA, mais de l’utiliser avec vigilance, curiosité et esprit critique.

Une IA peut être une aide à 100%, mais elle doit toujours rester un partenaire, jamais un substitut à notre discernement.